La teoría de decisión permite seleccionar una decisión de un conjunto de alternativas cuando existe incertidumbre sobre el futuro. Una decisión es una elección consciente y racional, orientada a conseguir un objetivo, que se realiza entre diversas posibilidades de actuación (o alternativas). Antes de tomar una decisión deberemos calcular cual será el resultado de escoger una alternativa.

TOMA DE DECISIONES BAJO CERTIDUMBRE

En la toma de decisión con certidumbre se asume que está disponible la información completa, de tal manera que el decisor conoce exactamente cuál será el resultado de cada alternativa que tome. El decisor es, pues, un previsor perfecto del futuro.

TOMA DE DECISIONES BAJO RIESGO

Una decisión con riesgo (también conocida como situación de decisión probabilística o estocástica) es tal que el decisor puede considerar varios estados de la naturaleza, cada uno con probabilidad dada de que ocurra. Así pues, en las situaciones de riesgo se asume que la totalidad de las probabilidades de ocurrencia de los estados de la naturaleza (y sus respectivos condicionales) se conocen o pueden estimarse.

TOMA DE DECISIONES BAJO INCERTIDUMBRE

En los procesos de decisión bajo incertidumbre, el decisor desconoce cuáles son los posibles estados de la naturaleza, aunque no dispone de información alguna sobre cuál de ellos ocurrirá. No solo es incapaz de predecir el estado real que se presentara, sino que además no puede cuantificar de ninguna forma esta incertidumbre

CRITERIOS DE DECISIÓN

Los criterios de decisión utilizados son:

· Criterio Maximin

· Criterio Maximax

· Criterio Arrepentimiento Min Max

· Valor esperado

· VEIPER

CRITERIO MAXIMIN (lo mejor de lo peor).

El decisor de este criterio es completamente pesimista, puesto que asume que pasará lo peor cuando haya seleccionado una alternativa. Para protegerse, el decisor seleccionará aquella alternativa que tenga un mayor valor siguiendo esta presunción pesimista. El tomador de decisiones incurre en una perdida por no escoger la mejor decisión.

CRITERIO MAXIMAX

El decisor optimista asume que ocurrirá el mejor resultado y seleccionará la alternativa con el mayor valor posible. Así pues, el decisor busca el mejor valor posible para cada alternativa. Este lo localiza en una nueva columna en la derecha de la tabla de decisión. Se selecciona la alternativa con el mejor valor en esta nueva columna.

CRITERIO DE ARREPENTIMIENTO MIN MAX

El criterio de arrepentimiento minimax utiliza el concepto de costo de oportunidad para llegar a una decisión. Consiste en que para cada acción y cada estado del mundo, se compara lo mejor que pudo haber sucedido en cada situación con lo que realmente sucedió.

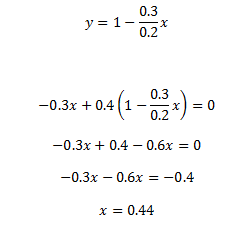

CRITERIO VALOR ESPERADO

El decisor de este criterio asume que todos los estados de la naturaleza son igualmente propensos a ocurrir; luego asigna a todos la misma probabilidad. Se calculan los valores esperados y se selecciona la alternativa con mejor valor esperado.

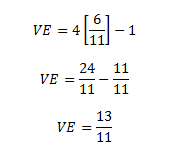

CRITERIO VEIPER: VALOR ESPERADO CON INFORMACION PERFECTA.

Límite superior que usted pagaría por un estudio de mercado

Veamos el siguiente ejemplo:

Suponga que una vendedora de periódicos desea saber cuántos periódicos pedir. Ella paga por cada periódico $20 y el precio de venta es igual a $25. Los periódicos que no se venden no tienen ningún valor. Se sabe que puede vender entre 6 y 10 periódicos al día, cada uno con una probabilidad de 0.2

Si la vendedora compra periódicos a $20 y vende estos periódicos a $25, entonces la ganancia será de $5.

Aplicando el criterio maxi-min se escogerá lo mejor de lo peor como sigue:

Aplicando el criterio maxi-max se escogerá lo mejor de lo mejor.

Aplicando el criterio de arrepentimiento se halla la matriz de arrepentimiento que es lo que se estaría dejando de ganar en cada acción.

De igual manera se procede con los demás.

En cuanto al VEIPER se calcula de la siguiente manera, escogiendo los valores perfectos:

Tomado de la página de internet: